När det gäller spel är det inget som slår PC-mästerskapet. Låt mig förklara. Nivån på anpassningsbarhet, liksom den råa kraften som en perfekt utformad anpassad spelrigg kan uppnå, är något konsoler bara kan drömma om. Med det sagt är även PC-spel benägen för vissa smuthullar och dessa smuthullar kan förstöra spelupplevelsen. Om du är en ardent gamer eller någon som håller ett öga på spelforum, måste du säkert ha hört talas om en av de största problemen för någon gamerskärmsliv. Medan det finns en traditionell lösning på det i form av V-Sync har nyare tekniker tagit fram andra lösningar i form av NVIDIAs G-Sync och AMDs FreeSync. Idag pitar vi dessa två G-Sync vs FreeSync för att se vilken som kommer ut på toppen. Men först låt oss kasta lite ljus på vad exakt problemet här är.

Vad är Screen Tearing?

Om du har spelat på en rigg som inte har en väldigt kraftfull bildskärm, måste du säkert ha stött på det här irriterande fenomenet som skärmar. Skärrskärning är en effekt som uppträder i en videokälla där 2 eller flera bildrutor visas tillsammans i en enda ram som orsakar en sönderfallande effekt. Du ser, eftersom GPU: erna blir allt kraftigare, vill de trycka så många ramar som de kan på kortast möjliga spänn. Även om det här låter bra, om din bildskärmens uppdateringshastighet är fixerad till si 75Hz, även om flera ramar för en animering trycks, är skärmen inte redo för den.

Tänk dig att du spelar ett spel på en GPU som kan trycka 100 bilder per sekund. Det innebär att monitorn uppdaterar sig 75 gånger per sekund, men videokortet uppdaterar displayen 100 gånger per sekund vilket är 33% snabbare än monitorn. Vad som händer är att i tiden mellan skärmuppdateringar har videokortet ritat en ram och en tredjedel av en annan. Den tredje av nästa ram kommer att skriva över den översta tredjedelen av föregående bildruta och sedan dra på skärmen. Videokortet avslutar sedan de sista 2/3 av den ramen och gör nästa 2/3 av nästa ram och sedan uppdateras skärmen igen.

Du kommer bara se en del av det som händer: en del av den aktuella ramen och en del av nästa ram (er). Som ett resultat ser det ut som om bilden på din skärm är uppdelad i flera delar och därigenom stör hela utseendet på spelet. En annan anledning till att detta kan hända är när systemets GPU är under tryck från stora mängder grafisk bearbetning eller dålig programmering. När GPU är under mycket press kommer det att misslyckas att hålla utmatningsvideoen synkroniserad och att skärmen ska riva.

V-Sync och behovet av ett alternativ

För någon spelare är skärmavbrott en irriterande händelse. En perfekt gjord titel kan helt förstöras av grova horisontella linjer och ramstammning. Utvecklarna insåg snart detta problem och tog ut V-Sync. Vertikal synkronisering eller V-Sync syftar till att lösa skärmproblemet med hjälp av dubbelbuffert.

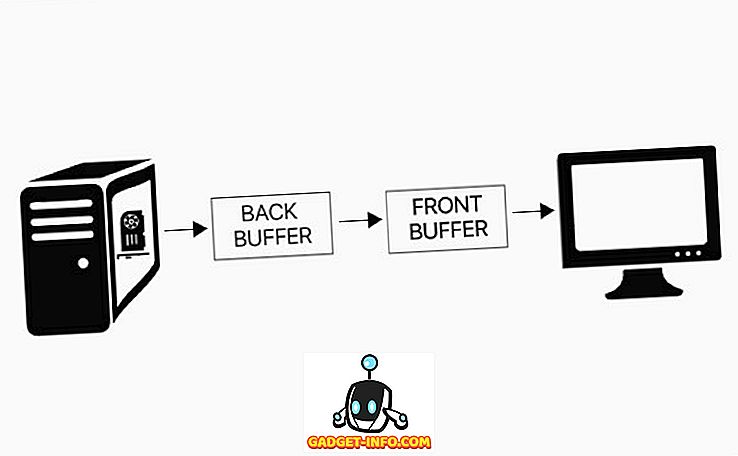

Dubbelpuffering är en teknik som mildrar tårproblemet genom att ge systemet en rambuffert och en backbuffert . När monitorn tar en ram att uppdatera med, drar den den från rambufferten. Videokortet ritar nya ramar i bakbufferten och kopierar sedan till rambufferten när den är klar. Enligt V-Syncs fördefinierade regler kan backbufferten inte kopiera till rambufferten till höger efter att monitoren har uppdaterats . Bakbufferten är fylld med en ram, systemet väntar och efter uppdateringen kopieras bakbufferten till rambufferten och en ny ram dras i bakbufferten, vilket effektivt klämmer fast din framerate vid uppdateringshastigheten.

Medan allt detta låter bra och hjälper till att ta bort skärmavbrott, kommer V-Sync med sin egen uppsättning nackdelar . I V-Sync kan din bildfrekvens endast vara lika med en diskret uppsättning värden lika med (Uppdatera / N), där N är något positivt heltal. Om din bildskärmens uppdateringshastighet är 60 Hz, till exempel, kommer de bildräntor som ditt system ska fungera att vara 60, 30, 20, 15, 12 och så vidare. Som du kan se är droppen från 60 fps till 30 fps stor. Även med hjälp av V-Sync kan en ramhastighet mellan 60 och 30 som ditt system troligen skulle kunna trycka ned till 30 bara.

Vidare är det största problemet med V-Sync ingångslaget. Som nämnts ovan, i fallet med V-Sync, kommer ramarna som GPU vill trycka först att hållas i bakbufferten och skickas endast till rambufferten när monitorn ger åtkomst till den. Det betyder att vad som helst som du ger till systemet kommer också att lagras i den bakre bufferten tillsammans med de andra ramarna. Endast när dessa ramar kommer att skrivas till huvudramen kommer din ingång att visas. Som sådan kan systemen drabbas av ingångslager på upp till 30 ms, vilket verkligen kan störa din spelupplevelse.

Alternativen: G-Sync och FreeSync

Du ser, det är traditionellt eller med hjälp av V-Sync, det har alltid varit den bildskärm som har orsakat problemen. Huvudströmmen har alltid givits till bildskärmarna, och de har missbrukat den för att begränsa ramarna som skjuts till dem. Oavsett hur många mjukvarunivåer du ändrar, kommer hårdvaran alltid att ha sina gränser. Men vad händer om det fanns en annan lösning, något som gjorde att GPUerna fick den högsta makten? Cue - Variabel Refresh Rate Monitorer .

Som namnet antyder är varvtalsmonitorer med bildskärmar med uppdateringshastighetskapvärde men utan en fast uppdateringshastighet. I stället förlitar de sig på GPU-fronten för att ändra sin uppdateringshastighet . Nu uppnås denna prestation med hjälp av någon av de två teknologierna - NVIDIA G-Sync eller AMD FreeSync.

NVIDIAs G-Sync lanserades 2013, och syftar till att lösa problemet genom att ge GPU den ultimata rätten att bestämma hur många ramar som ska tryckas på skärmen. Skärmen, istället för att ha en fast uppdateringshastighet, anpassar sig till GPU: s bearbetningshastighet och matchar den utmatade fps-hastigheten . Så, till exempel, spelar du ett spel på 120 bilder per sekund, så blir din bildskärm också uppfriskande vid 120 Hz (120 gånger per sekund). Och när det gäller ett högt grafiskt bearbetningskrav, där din GPU släpper ramarna till 30fps, ändrar skärmen följaktligen sin uppdateringshastighet till 30 Hz. Som sådan finns det ingen förlust i ramarna, och datan sköts direkt till displayen, vilket eliminerar eventuellt utrymme för riva eller ingående lagring.

Nu, medan NVIDIA är kungen när det gäller spel, är den största konkurrenten AMD det inte bakom. Så när NVIDIA tog ut G-Sync, hur kunde AMD stanna kvar? För att stanna i tävlingen tog AMD ut sin lösning på V-Sync-teknologi - FreeSync. AMDs FreeSync har utgått 2015 med samma princip som NVIDIAs G-Sync genom att låta GPU vara mästaren och styra uppdateringshastigheten för bildskärmen. Medan syftet med både G-Sync och FreeSync är densamma ligger skillnaden mellan de två i hur de går för att uppnå det.

G-Sync vs FreeSync: Hur fungerar de?

NVIDIA utformade G-Sync för att fixa problem i båda ändarna. G-Sync är en proprietär adaptiv synkroniseringsteknik, vilket innebär att den använder sig av extra hårdvaru-modul . Detta extrachip är inbyggt i varje stödd bildskärm, och det gör det möjligt för NVIDIA att finjustera upplevelsen baserat på dess egenskaper som maximal uppdateringshastighet, IPS eller TN-skärmar och spänning. Även när din bildfrekvens blir super låg eller super hög kan G-Sync hålla ditt spel snyggt.

När det gäller AMDs FreeSync krävs ingen sådan modul . I 2015 tillkännagav VESA Adaptive-Sync som komponent i DisplayPort 1.2a-specifikationen. FreeSync använder sig av protokollen för DisplayPort Adaptive-Sync för att tillåta GPU att ta kontroll över uppdateringshastigheterna. Dessutom utvidgade det senare sitt stöd till HDMI-portar, vilket gör det tilltalande för ett högre antal konsumenter.

spökbilder

I aspekten av bildskärmar används spökning för att beskriva en artefakt som orsakas av en långsam responstid . När skärmen uppdateras uppfattar det mänskliga ögat fortfarande bilden som tidigare visats. orsakar en utsmyckning eller suddig visuell effekt. Svarstiden är ett mått på hur snabbt en given pixel kan ändra tillstånd från en färg till en annan färg. Om din bildskärms svarstid inte synkroniseras med de ramar som GPU-enheten trycker på, är det troligt att du upplever spöken. Denna effekt är framträdande bland de flesta LCD- eller plattskärmar. Även om det inte är väsentligen skärmavbrott, är spöken inte långt ifrån konceptet, med tanke på att nya ramar överläggs på de tidigare ramarna utan att de helt försvinner från skärmen.

Eftersom NVIDIAs G-Sync-modul fungerar med hjälp av en tilläggsmodul, möjliggör G-Sync att förhindra spöken genom att anpassa hur modulen fungerar på varje bildskärm. Med AMDs FreeSync görs dessa justeringar inom Radeon-drivrutinen själv och tar uppgiften bort från monitorn. Som du kan se är det här en maskinvara vs programvarukontrollmodul här, och NVIDIA vinner enkelt här. Medan spöken inte är vanlig på FreeSync-skärmar, är den fortfarande kvar . Å andra sidan, eftersom varje bildskärm är fysiskt tweaked och avstämd, upplever G-Sync inga spökningar på dess paneler.

Flexibilitet

I strävan att lösa skärmavbrott har lösningen varit att ge slutlig kontroll över GPU. Men som farbror Ben sa en gång, "med stor kraft kommer stort ansvar". I det här fallet tar GPU bort alla krafterna från bildskärmen, mer eller mindre. Du måste till exempel vara medveten om att de flesta bildskärmar, förutom normal ljusstyrka och kontrastjusteringar, också har egna funktioner som gör det möjligt för bildskärmen att justera inställningarna dynamiskt baserat på ingången som levereras till dem.

Eftersom NVIDIAs G-Sync använder en extra proprietär modul tar den bort funktionen från bildskärmen genom att möjliggöra dynamiska anpassningar till GPU. Å andra sidan gör AMDs FreeSync inga sådana ändringar och gör det möjligt för skärmen att ha en dynamisk färgjusteringsfunktion av sig själv. Att ha dina personliga ändringar som ett alternativ är viktigt för någon tillverkare, eftersom det hjälper dem att få kanten över andra tillverkare. Det är därför många tillverkare föredrar att välja FreeSync över G-Sync.

G-Sync vs FreeSync: Kompatibla enheter

För att någon enhet ska vara kompatibel med NVIDIAs G-Sync-modul måste den bädda in NVIDIAs proprietära modulchip inom sina displayer. Å andra sidan kan AMDs FreeSync användas av någon bildskärm som har en variabel uppdateringshastighet och antingen en DisplayPort eller HDMI-port.

Med det sagt måste din GPU också vara kompatibel med deras respektive tekniker (ja, du kan inte blanda och matcha GPU hos en tillverkare med den andra synkroniseringsmetoden). Efter att ha introducerats nästan 2 år tidigare än konkurrenten har NVIDIA G-Sync ganska många GPU-enheter under den stödda taggen för G-Sync. Alla mitten till avancerade GPU: er från 600 till 1000-serien bär märket för G-Sync på dem.

På samma sätt stöder AMD vid tidpunkten för detta skrivande endast 9 GPUer som använder sig av FreeSync-tekniken, jämfört med NVIDIAs 33. Vidare har NVIDIA även utökat sitt G-Sync-stöd till bärbara datorer och bärbara datorer, en funktion som för närvarande saknas från AMDs FreeSync.

NVIDIA G-Sync Kompatibla enheter

| GTX 600-serien | GTX 700-serien | GTX 900-serien | GTX 1000-serien | Titan-serien |

|---|---|---|---|---|

| GeForce GTX 650 Ti Boost | GeForce GTX 745 | GeForce GTX 950 | GeForce GTX 1050 | GeForce GTX Titan |

| GeForce GTX 660 | GeForce GTX 750 | GeForce GTX 960 | GeForce GTX 1050 Ti | GeForce GTX Titan Black |

| GeForce GTX 660 Ti | GeForce GTX 750 Ti | GeForce GTX 965M | GeForce GTX 1060 | GeForce GTX Titan X |

| GeForce GTX 670 | GeForce GTX 760 | GeForce GTX 970 | GeForce GTX 1070 | GeForce GTX Titan Xp |

| GeForce GTX 680 | GeForce GTX 770 | GeForce GTX 970M | GeForce GTX 1080 | GeForce GTX Titan Z |

| GeForce GTX 690 | GeForce GTX 780 | GeForce GTX 980 | GeForce GTX 1080 Ti | |

| GeForce GTX 780 Ti | GeForce GTX 980M | |||

| GeForce GTX 980 Ti |

AMD FreeSync-kompatibla enheter

| GPUs | APU |

|---|---|

| Radeon R7 260X | Kaveri |

| Radeon R7 360 | Kabini |

| Radeon R9 285 | Temash |

| Radeon R9 290 | Beema |

| Radeon R9 290X | Mullins |

| Radeon R9 380 | Carrizo |

| Radeon R9 390 | Bristol Ridge |

| Radeon R9 390X | Raven Ridge |

| Radeon R9 Fury X |

Designkostnad och tillgänglighet

NVIDIAs G-Sync använder sig av en extra hårdvara, vilket i grunden betyder att skärmverkare måste göra mer utrymme inuti bildskärmens hölje . Även om det inte kan tyckas som en stor sak, ökar utvecklingsutgifterna avsevärt genom att skapa en anpassad produktdesign för en typ av bildskärm. Å andra sidan är AMDs tillvägagångssätt mycket öppet, där bildskärmar kan inkludera tekniken i sina befintliga mönster.

För att visa dig en större bild (ingen ordspråk) kommer LGs 34-tums Ultrawide-monitor med FreeSync-stöd bara att kosta dig $ 397. Medan en av de billigaste ultravioletta bildskärmarna för närvarande finns, kommer LGs 34-tums alternativ med G-Sync-stöd att sätta dig tillbaka till $ 997. Det är nästan en $ 600 skillnad, som lätt kan vara avgörande när du gör ditt nästa köp.

G-Sync vs FreeSync: Den bästa variabla uppdateringshastighetslösningen?

Både NVIDIA G-Sync och AMD FreeSync utreder framgångsrikt problemet med skärmavbrott. Medan G-Sync-tekniken är definitivt dyrare, stöds den på ett bredare utbud av GPUer och det erbjuder också nollghosting. AMDs FreeSync i den andra änden syftar till att erbjuda ett billigare alternativ, och medan antalet monitorer som stöder det är ganska högt, stöds inte många vanliga GPUer från och med nu. I slutändan är valet i dina händer, men du kunde inte gå fel med någon av de två. Berätta om andra frågor du kan ha i kommentarfältet nedan, och vi försöker vårt bästa för att hjälpa dig.